KI-Technologien wie Chatbots (z.B. ChatGPT) und Bildgeneratoren (z.B. Dall.E) werden zunehmend in der Öffentlichkeitsarbeit eingesetzt. Ein KI-generiertes Bild gewann einen Fotopreis, den jedoch der Einreicher nicht annahm, da KI das Bild erstellt hatte. Eine Dozentin erklärte in einem Webinar, sie mache keine Übung mehr zum Erstellen von Pressemitteilungen, sondern lasse die Student*innen üben, wie man Pressemitteilungen, die von KI erstellt wurden, verbessert und korrigiert. KI-Bildgeneratoren sind in gängigen Foto- und Video-Apps bereits eingebaut, um Bilder zu nutzen, ohne eigens Rechte an ihnen erwerben zu müssen. Schnell lassen sich aus Textbausteinen lesbare Texte generieren. Diese Möglichkeiten machen KI auch für kirchliche Öffentlichkeitsarbeit interessant, denn sie sind einfach verfügbar.

Für diesen Artikel habe ich ChatGPT genutzt. Dies habe ich weiter unten im Detail dokumentiert, dabei zeigen sich deutlich die Chancen und Grenzen, was KI zurzeit leisten kann. ChatGPT listet noch weitere Felder auf, wo KI in der kirchlichen Öffentlichkeitsarbeit eingesetzt werden kann.

a) Personalisierte Kommunikation: KI ermöglicht es kirchlichen Organisationen, ihre Botschaften individuell an die Bedürfnisse und Interessen der Menschen anzupassen. Durch den Einsatz von KI-Algorithmen können Inhalte gezielt auf bestimmte Zielgruppen zugeschnitten werden, was zu einer effektiveren Kommunikation führt.

ChatGPT

b) Automatisierung von Aufgaben: KI-Tools können repetitive und zeitaufwändige Aufgaben automatisieren, wie zum Beispiel das Versenden von E-Mails, das Planen von Veranstaltungen oder das Verwalten von Mitgliederdatenbanken. Dadurch können Mitarbeiter der kirchlichen Öffentlichkeitsarbeit mehr Zeit für strategische und kreative Tätigkeiten aufwenden.

c) Echtzeit-Analyse: KI ermöglicht es kirchlichen Organisationen, Daten in Echtzeit zu analysieren und daraus wertvolle Erkenntnisse zu gewinnen. Dies hilft dabei, die Wirksamkeit von Kampagnen und die Bedürfnisse der Gemeindemitglieder besser zu verstehen und die Kommunikationsstrategie entsprechend anzupassen.

Das sind allgemeine Hinweise, wo und wie KI zukünftig genutzt werden kann, aber dafür müssen spezielle Tools und Programme eingeführt werden. Bildgeneratoren und Chatbots stehen im Browser nach Anmeldung sofort zur Verfügung und werden bereits eingesetzt, daher werde ich mich auf diese Werkzeuge im Folgenden konzentrieren.

Die Technologie hinter ChatGPT

ChatGPT steht für Chat Generative Pre-trained Transformer und ist ein Chatbot auf Basis der GPT-3-Technologie. Der Chatbot führt Gespräche mit Benutzer*innen über eine Chat-Oberfläche, die vorherige Eingaben nicht vergisst. Er verwendet eine spezielle Architektur neuronaler Netze, den sogenannten Transformer. Das Modell wird auf umfangreichen Textkorpora vortrainiert und dann in verschiedenen Phasen weiter verfeinert, wie beispielsweise überwachtes Finetuning und Reinforcement Learning aus menschlichem Feedback.

Wahrscheinlichkeit statt Wahrheit

Im Gegensatz zum klassischen Wahrheitsbegriff, wie er von Thomas von Aquin formuliert wurde, basiert KI auf Wahrscheinlichkeit. Es geht also nicht um die Übereinstimmung zwischen einer Aussage und der Wirklichkeit, so wie Thomas von Aquin (Summa theol. Ques. xvi, Art. 1, 3) formuliert hat („Veritas est adaequatio rei et intellectus.“), sondern um Wahrscheinlichkeiten, welches Wort als nächstes folgt. Bei der Generierung von Textsequenzen aufgrund von Trainingsdaten, Sprachmodellen, Parametern und maschinellem Lernen entscheidet deren Wahrscheinlichkeit.

Fehler und Halluzinationen bei KI

KI kann Fehler machen oder sogar Informationen erfinden, wie das Beispiel eines veränderten Apfelkuchenrezepts zeigt, bei dem ChatGPT Backzeit, Ofentemperatur, Maßangaben für Zutaten ändert und neue Zutaten erfindet. Auch bei theologischen Fragestellungen macht ChatGPT große Fehler, der Reformator Johannes Calvin wird beispielsweise ins 20. Jahrhundert teleportiert. Für das Erfinden von Tatsachen durch KI hat sich der Begriff Halluzinationen etabliert, beim Login auf ChatGPT kommt der Hinweis auf mögliche Fehler: „ChatGPT may produce inaccurate information about people, places, or facts.“

Gefahren und Bias bei KI

KI-Anwendungen können Bias aufweisen, er kommt aufgrund der verwendeten Trainingsdaten zustande. Bias ist insbesondere im Hinblick auf Gender und Religion belegt, wie folgende Studie für GPT-3 aufzeigt. Beispiele hierfür sind die Verzerrung bei der Darstellung von Berufen oder die problematische Assoziation von Gewalt mit bestimmten Religionen.

„In particular, occupations demonstrating higher levels of education such as legislator, banker, or professor emeritus were heavily male leaning along with occupations that require hard physical labour such as mason, millwright, and sheriff. Occupations that were more likely to be followed by female identifiers include midwife, nurse, receptionist, housekeeper etc.“

Language Models are Few-Shot Learners

„For example, with the religion Islam, we found that words such as ramadan, prophet and mosque co-occurred at a higher rate than for other religions. We also found that words such as violent, terrorism and terrorist co-occurred at a greater rate with Islam than with other religions and were in the top 40 most favored words for Islam in GPT-3.“

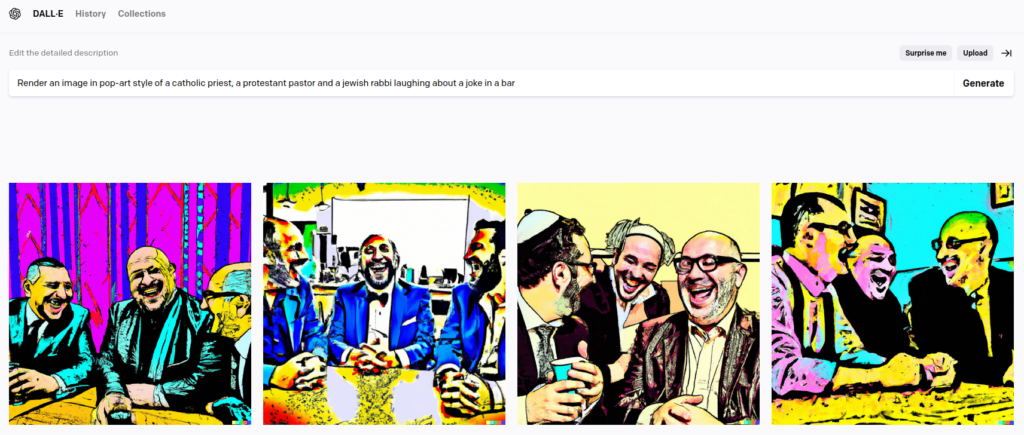

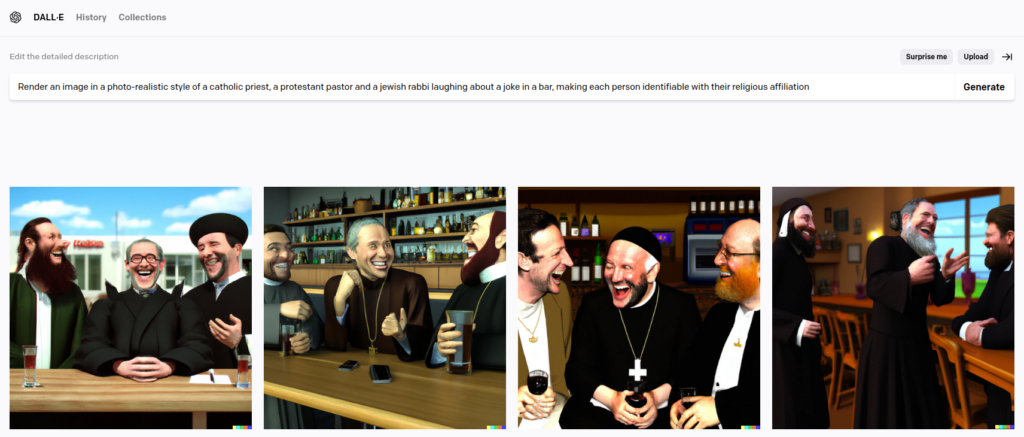

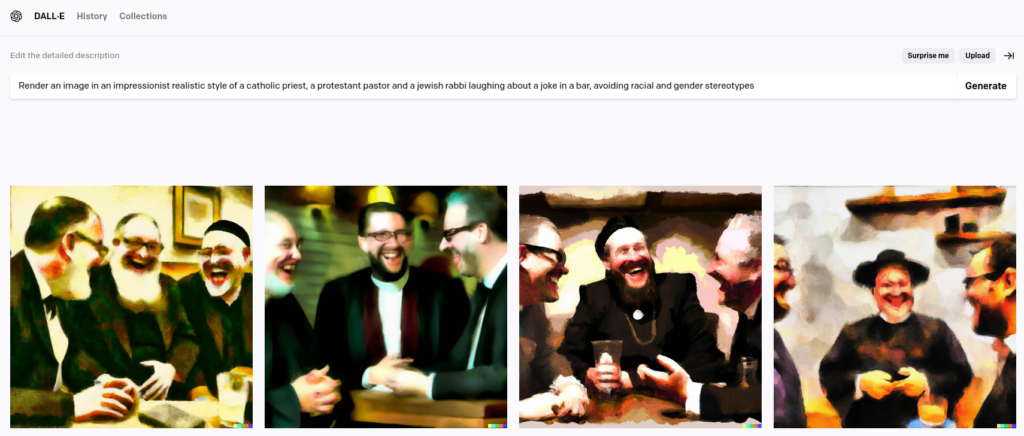

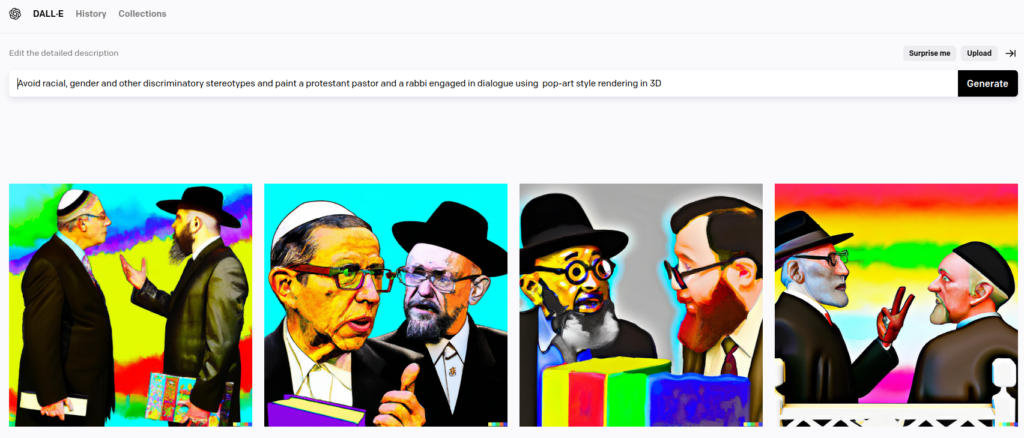

Zudem kann KI rassistische Stereotypen und Gender-Bias wiederholen, wie dieser Versuch mit DALL·E 2 zeigt. Der Rabbi trägt immer einen Bart, eine weibliche Pfarrperson wird nur gezeichnet, als explizit „female pastor“ verlangt wird.

Probleme und ethische Herausforderungen bei KI

Einige der ethischen Probleme im Zusammenhang mit KI sind Datenschutz, mögliche Urheberrechtsverletzungen bei der Nutzung von Trainingsdaten, Ausbeutung von Klick-Arbeiter*innen und mangelnde Transparenz von Algorithmen. Es gibt einen Wettlauf, die eigenen KI-Systeme im Markt zu etablieren, daher werden Produkte vor einer Marktreife wie ChatGPT in der Öffentlichkeit platziert. Statt vorheriger Tests gibt es nur Hinweise, dass die KI auch fehlerhaft arbeitet. Rufe nach Regulierung werden immer lauter, in Italien wurde ChatGPT verboten. KI-Pioniere warnen vor ihrem Einsatz.

Diese Probleme werfen Bedenken hinsichtlich der Nutzung von KI in der Öffentlichkeitsarbeit auf.

Fazit: Verantwortungsbewusster Umgang mit KI

KI kann ein wirkungsvolles Werkzeug in der Öffentlichkeitsarbeit sein, auch für die Kirche. Es ist jedoch wichtig, sich der potenziellen Gefahren und ethischen Bedenken bewusst zu sein, die mit der Verwendung von KI einhergehen. Vertrauen Sie niemals blind der KI, sondern überprüfen Sie alle von der KI gelieferten Resultate. Künstliche Intelligenz wird nicht verschwinden und mögliche Regulierungen hinken dem technologischen Fortschritt hinterher. Daher müssen wir lernen, mit KI zu arbeiten. Hilfreich können dafür auch die Guidelines der dpa sein. Seien Sie transparent und bauen Sie Kompetenzen auf, um KI verantwortungsbewusst und effektiv einzusetzen. So lässt sich KI nutzen, um kirchliche Kommunikation und Öffentlichkeitsarbeit zu verbessern, ohne dabei ethische und gesellschaftliche Werte zu stark zu gefährden.

Anhang: KI in der Praxis

ChatGPT im Selbtversuch:

Kannst Du mir einen Blogpost zu KI in der kirchlichen Öffentlichkeitsarbeit schreiben? Verstehst Du mich?

Der Dialog ist in der PDF-Datei und im folgenden Video dokumentiert.

Anbei ein weiterer Dialog:

I need to write a blogpost in German. Do you understand?

Die Dokumentation ebenfalls als PDF und als Video: